Duboko učenje

Duboko učenje je podoblast mašinskog učenja zasnovana na korišćenju neuronskih mreža. Pridjev "duboko" odnosi se na korištenje više slojeva u mreži. Korištene metode mogu biti supervizirane, polu-supervizirane ili nesupervizirane . [2]

Arhitekture dubokog učenja kao što su duboke neuronske mreže, mreže dubokih verovanja, rekurentne neuronske mreže, konvolucione neuronske mreže i transformeri primenjuju se u oblastima uključujući računarsku viziju, prepoznavanje govora, prirodno jezičko procesiranje, mašinsko prevođenje, bioinformatiku, dizajn lekova, analiza medicinskih slika, klimatske nauke, inspekciju materijala i programe za društvene igre, gde su postigli rezultate koji su ponekad nadmašili ljudsku stručnost. [3] [4] [5]

Rani oblici neuronskih mreža inspirisane su procesiranjem informacija i distribuiranim komunikacionim čvorovima u biološkim sistemima, posebno u ljudskom mozgu. Međutim, trenutne neuronske mreže ne pokušavaju da modeliraju funkciju mozga organizama i generalno se smatraju modelima niskog kvaliteta za tu svrhu [6]

Moderni algoritmi dubokog učenja se zasnivaju na neuronskim mrežama sa više slojeva. Slojevi se sastoje od neurona. Neki od tipa neuronskih mreža koje imaju ovakvu arhitekturu jesu konvolucione neuronske mreže, kao i transformeri.. [7]

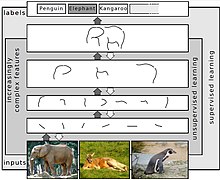

U suštini, duboko učenje se odnosi na algoritme mašinskog učenja koji imaju određenu hijerarhiju slojeva. Ova sekvencija slojeva služi da pretvori ulazne podatke u neku određenu astrakciju i složenu reprezentaciju tog ulaza. U slučaju računarskoj vida, prvi sloj može predstavljati apstrakcije u vidu linija i krugova, zatim drugi sloj, može prepoznati ivice, dok sledeći sloj može prepoznavati kompleksnije oblike, poput nosa, usta i očiju u slučaju rešavanja problema detekcije lica.

Važno je napomenuti da proces dubokog učenja može sam da nađe mesto gde će koje karakteristike naučiti u arhitekturi. Prije dubokog učenja, tehnike mašinskog učenja često su uključivale ručno pravljene karakteristike gde bi se podaci transformisali u prikladniji oblik za algoritam sa kojim će raditi. U pristupu dubokog učenja, karakteristike nisu ručno izrađene i model automatski otkriva korisne karakteristike iz podataka. Ovo ne eliminiše potrebu za ručnim podešavanjem; na primjer, parametri poput broj slojeva i broj neurona po sloju mogu različito uticati na proces konvergencije i pronalaženje modela koji najbolje radi za dati problem. [8] [2]

Riječ "duboko" u terminu "duboko učenje" odnosi se na broj slojeva kroz koje se podaci transformiraju. Preciznije, sistemi dubokog učenja imaju značajnu dubinu kreditnog puta (eng. credi assignment path, CAP). CAP je lanac transformacija od ulaza do izlaza. CAP-ovi opisuju potencijalno uzročne veze između ulaza i izlaza. Za "feedforward" neuronsku mrežu, dubina CAP-ova je dubina mreže, gde predstavlja broj skrivenih slojeva plus jedan (pošto je izlazni sloj također parametriran). Za rekurentne neuronske mreže, u kojima se signal može propagirati kroz sloj više puta, dubina CAP-a je potencijalno neograničena. [9] Nijedan univerzalno dogovoreni prag dubine ne dijeli plitko učenje od dubokog učenja, ali većina istraživača se slaže da duboko učenje uključuje CAP dubinu veću od 2. Pokazalo se da je CAP dubine 2 univerzalni aproksimator u smislu da može emulirati bilo koju funkciju. [10] Osim toga, više slojeva ne doprinosi boljoj sposobnosti aproksimatora funkcije mreže. Duboki modeli (CAP > 2) mogu izdvojiti bolje karakteristike od plitkih modela i stoga dodatni slojevi pomažu u efikasnom učenju karakteristika, ali veći broj slojeva takođe može dovesti i do problema [[nadprilagođavanja]] modela.

Arhitekture mreža dubokog učenja mogu biti konstruisane po principu pohlepnog algoritma za svaki sloj u arhitekturi. Svaki sloj pronalazi najoptimalnije rešenje za taj sloj, dok metode dubokog učenja pomažu da odluče koje od ovih apstrakcija najoptimalnije rešavaju zadati problem.

Algoritmi dubokog učenja mogu se primijeniti na zadatke učenja bez supervizije. Ovo je važna prednost jer su nelabelirani podaci mnogo brojniji od labeliranih podataka. Primjeri ovakvih struktura koje se mogu obučiti na način bez supervizije su mreže duboke verovatnoće . [8] [11]

Duboke neuronske mreže se generalno tumače u terminima teoreme univerzalne aproksimacije [12] [13] [14] [15] ili probabilističkog zaključivanja . [16] [17] [8] [9] [18]

Inicijalno su postojale su dvije vrste veštačkih neuronskih mreža (ANN): feedforward neuronske mreže (FNN) i rekurentne neuronske mreže (RNN). RNN-ovi su bazirani na cikličnom povezivanju u svojoj arhitekturi, dok FNN nisu. Wilhelm Lenz i Ernst Ising su kreirali Izingov model [19] koji je u suštini RNN arhitektura koja se ne može trenirati i koja se sastoji od elemenata sličnih neuronima. Godine 1972. Shun'ichi Amari je ovu arhitekturu učinio adaptivnom. [20] [21] Njegovu RNN koja može da uči, jeste popularizirao John Hopfield 1982. [22]

Krajem 2000-ih, duboko učenje je počelo da nadmašuje druge metode u takmičenjima u mašinskom učenju. Godine 2009., LSTM mreža (Alex Graves et al) [23] je bio prvi RNN koji je pobijedio na takmičenjima, pobijedivši u tri takmičenja u prepoznavanju rukopisa.

Značajni uticaji na prepoznavanje slika ili objekata osjetili su se od 2011. do 2012. godine. Iako su CNN-ovi obučeni propagacijom unazad postojali decenijama, [24] [25] kao i GPU implementacije neuronskih mreža godinama, [26] uključujući i CNN-ove, [9] bile su potrebne brže implementacije CNN-a na GPU-ima za napredak u kompjuterskom vidu . Godine 2011. DanNet [27] [3] Dana Ciresana, Ueli Meier, Jonathan Masci, Luca Maria Gambardella i Jürgen Schmidhuber postigao je po prvi put nadljudsku izvedbu na takmičenju u prepoznavanju vizuelnih obrazaca, nadmašujući tradicionalne metode za faktor od 3 [9] Takođe 2011. DanNet je pobijedio na ICDAR takmičenju kineskog rukopisa, u maju 2012. pobijedio je na ISBI takmičenju za segmentaciju slika. CNN-ovi do 2011. nisu igrali veliku ulogu na konferencijama o kompjuterskom vidu, ali je u junu 2012. objavljen rad Ciresana et al. na vodećoj konferenciji CVPR [3] pokazao je kako maksimalno udruživanje CNN-ova na GPU može dramatično poboljšati mnoge rekorde za mjerenje vida. U septembru 2012. DanNet je također pobijedio na ICPR takmičenju za analizu velikih medicinskih slika za otkrivanje raka, a naredne godine i na MICCAI Grand Challenge-u na istu temu. [28] U oktobru 2012. sličan AlexNet od Alexa Krizhevskyja, Ilye Sutskevera i Geoffreya Hintona [4] pobijedio je na velikom takmičenju ImageNet sa značajnom razlikom u odnosu na plitke metode mašinskog učenja. Mreža VGG-16 Karen Simonyan i Andrewa Zissermana dodatno je smanjila stopu greške i pobijedila na takmičenju ImageNet 2014, prateći sličan trend u prepoznavanju govora velikih razmjera.

Klasifikacija slika je zatim proširena na izazovniji zadatak generiranja opisa (naslova) za slike, često kao kombinacija CNN-a i LSTM-a. [29] [30] [31]

Veštačke neuronske mreže ( ANN ) ili konekcionistički sistemi su računarski sistemi inspirisani biološkim neuronskim mrežama koje čine životinjski mozak. Takvi sistemi uče (progresivno poboljšavaju svoju sposobnost) da rade zadatke razmatranjem primjera, općenito bez programiranja specifičnog za zadatak. Na primjer, u prepoznavanju slika, mogli bi naučiti identificirati slike koje sadrže mačke analizom primjera slika koje su ručno označene kao "mačka" ili "bez mačke" i korištenjem analitičkih rezultata za identifikaciju mačaka na drugim slikama. Najviše su koristili u aplikacijama koje je teško izraziti tradicionalnim kompjuterskim algoritmom koristeći programiranje zasnovano na pravilima .

- ↑ Schulz, Hannes; Behnke, Sven (1 November 2012). „Deep Learning” (en). KI - Künstliche Intelligenz 26 (4): 357–363. DOI:10.1007/s13218-012-0198-z. ISSN 1610-1987.

- ↑ 2,0 2,1 LeCun, Yann; Bengio, Yoshua; Hinton, Geoffrey (2015). „Deep Learning”. Nature 521 (7553): 436–444. Bibcode 2015Natur.521..436L. DOI:10.1038/nature14539. PMID 26017442.

- ↑ 3,0 3,1 3,2 . ISBN 978-1-4673-1228-8.

- ↑ 4,0 4,1 Krizhevsky, Alex; Sutskever, Ilya; Hinton, Geoffrey (2012). „ImageNet Classification with Deep Convolutional Neural Networks”. NIPS 2012: Neural Information Processing Systems, Lake Tahoe, Nevada. Arhivirano iz originala na datum 2017-01-10. Pristupljeno 2017-05-24.

- ↑ „Google's AlphaGo AI wins three-match series against the world's best Go player”. TechCrunch. 25 May 2017. Arhivirano iz originala na datum 17 June 2018. Pristupljeno 17 June 2018.

- ↑ „Study urges caution when comparing neural networks to the brain” (en). MIT News | Massachusetts Institute of Technology. 2022-11-02. Pristupljeno 2023-12-06.

- ↑ Bengio, Yoshua (2009). „Learning Deep Architectures for AI”. Foundations and Trends in Machine Learning 2 (1): 1–127. DOI:10.1561/2200000006. Arhivirano iz originala na datum 4 March 2016. Pristupljeno 3 September 2015.

- ↑ 8,0 8,1 8,2 Bengio, Y.; Courville, A.; Vincent, P. (2013). „Representation Learning: A Review and New Perspectives”. IEEE Transactions on Pattern Analysis and Machine Intelligence 35 (8): 1798–1828. arXiv:1206.5538. DOI:10.1109/tpami.2013.50. PMID 23787338. Greška u referenci: Nevaljana oznaka

<ref>; naziv "BENGIO2012" je zadan više puta s različitim sadržajem - ↑ 9,0 9,1 9,2 9,3 Schmidhuber, J. (2015). „Deep Learning in Neural Networks: An Overview”. Neural Networks 61: 85–117. arXiv:1404.7828. DOI:10.1016/j.neunet.2014.09.003. PMID 25462637.Schmidhuber, J. (2015). "Deep Learning in Neural Networks: An Overview". Neural Networks. 61: 85–117. arXiv:1404.7828. doi:10.1016/j.neunet.2014.09.003. PMID 25462637. S2CID 11715509. Greška u referenci: Nevaljana oznaka

<ref>; naziv "SCHIDHUB" je zadan više puta s različitim sadržajem - ↑ . ISBN 978-1-5225-8218-2.

- ↑ Hinton, G.E. (2009). „Deep belief networks”. Scholarpedia 4 (5): 5947. Bibcode 2009SchpJ...4.5947H. DOI:10.4249/scholarpedia.5947.

- ↑ Cybenko (1989). „Approximations by superpositions of sigmoidal functions”. Mathematics of Control, Signals, and Systems 2 (4): 303–314. DOI:10.1007/bf02551274. Arhivirano iz originala na datum 10 October 2015.

- ↑ Hornik, Kurt (1991). „Approximation Capabilities of Multilayer Feedforward Networks”. Neural Networks 4 (2): 251–257. DOI:10.1016/0893-6080(91)90009-t.

- ↑ . ISBN 978-0-13-273350-2.

- ↑ . ISBN 978-0-262-08239-6.

- ↑ Orhan, A. E.; Ma, W. J. (2017). „Efficient probabilistic inference in generic neural networks trained with non-probabilistic feedback”. Nature Communications 8 (1): 138. Bibcode 2017NatCo...8..138O. DOI:10.1038/s41467-017-00181-8. PMC 5527101. PMID 28743932.

- ↑ Deng, L.; Yu, D. (2014). „Deep Learning: Methods and Applications”. Foundations and Trends in Signal Processing 7 (3–4): 1–199. DOI:10.1561/2000000039. Arhivirano iz originala na datum 2016-03-14. Pristupljeno 2014-10-18.

- ↑ . ISBN 978-0-262-01802-9.

- ↑ Brush, Stephen G. (1967). „History of the Lenz-Ising Model”. Reviews of Modern Physics 39 (4): 883–893. Bibcode 1967RvMP...39..883B. DOI:10.1103/RevModPhys.39.883.

- ↑ Amari, Shun-Ichi (1972). „Learning patterns and pattern sequences by self-organizing nets of threshold elements”. IEEE Transactions C (21): 1197–1206.

- ↑ Schmidhuber, Jürgen. „Annotated History of Modern AI and Deep Learning”. MISSING LINK. .

- ↑ Hopfield, J. J. (1982). „Neural networks and physical systems with emergent collective computational abilities”. Proceedings of the National Academy of Sciences 79 (8): 2554–2558. Bibcode 1982PNAS...79.2554H. DOI:10.1073/pnas.79.8.2554. PMC 346238. PMID 6953413.

- ↑ Graves, Alex; Fernández, Santiago; Gomez, Faustino; Schmidhuber, Jürgen (2006). „Connectionist temporal classification: Labelling unsegmented sequence data with recurrent neural networks”. Proceedings of the International Conference on Machine Learning, ICML 2006: 369–376.

- ↑ Zhang, Wei (1988). „Shift-invariant pattern recognition neural network and its optical architecture”. Proceedings of Annual Conference of the Japan Society of Applied Physics.

- ↑ LeCun et al., "Backpropagation Applied to Handwritten Zip Code Recognition", Neural Computation, 1, pp. 541–551, 1989.

- ↑ Oh, K.-S.; Jung, K. (2004). „GPU implementation of neural networks”. Pattern Recognition 37 (6): 1311–1314. Bibcode 2004PatRe..37.1311O. DOI:10.1016/j.patcog.2004.01.013.

- ↑ Ciresan, D. C.; Meier, U.; Masci, J.; Gambardella, L.M.; Schmidhuber, J. (2011). „Flexible, High Performance Convolutional Neural Networks for Image Classification”. International Joint Conference on Artificial Intelligence. DOI:10.5591/978-1-57735-516-8/ijcai11-210. Arhivirano iz originala na datum 2014-09-29. Pristupljeno 2017-06-13.

- ↑ . ISBN 978-3-642-38708-1.

- ↑ Vinyals, Oriol; Toshev, Alexander; Bengio, Samy; Erhan, Dumitru (2014). „Show and Tell: A Neural Image Caption Generator”. arXiv:1411.4555 [cs.CV]..

- ↑ Fang, Hao; Gupta, Saurabh; Iandola, Forrest; Srivastava, Rupesh (2014). „From Captions to Visual Concepts and Back”. arXiv:1411.4952 [cs.CV]..

- ↑ Kiros, Ryan; Salakhutdinov, Ruslan; Zemel, Richard S (2014). „Unifying Visual-Semantic Embeddings with Multimodal Neural Language Models”. arXiv:1411.2539 [cs.LG]..